SOTA of MIMIC III, in 2022, micro-f1 = 59.9 (ReRanker, 2-stage)

key idea #

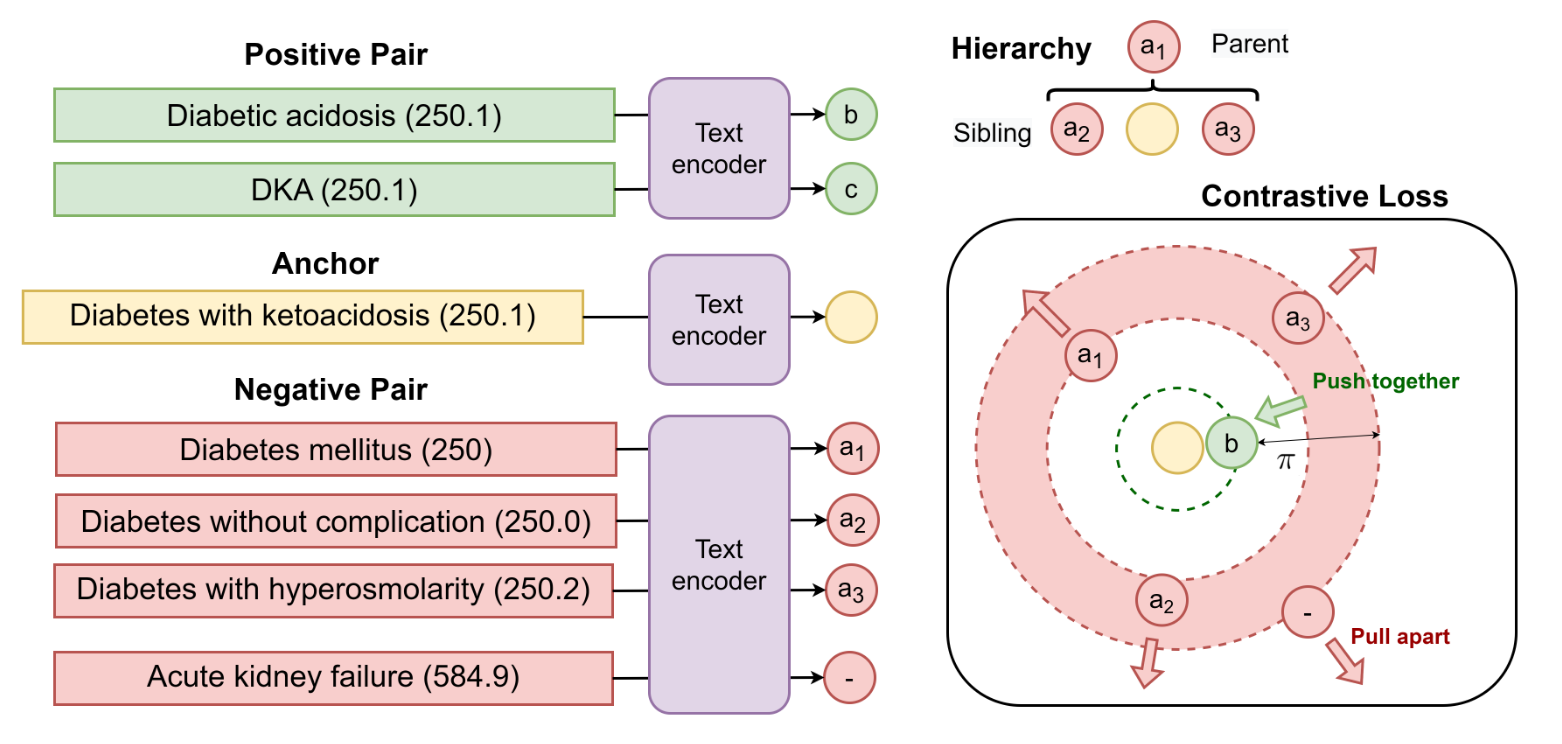

利用UMLS 2021AA知识图谱(4.4M实体)的层次化知识进行对比学习的预训练,并为不同的负样本(UMLS中的邻节点、父节点、不相关节点)设置不同的软间隔

- 在这之前先进行MIMIC III上的完型填空预训练

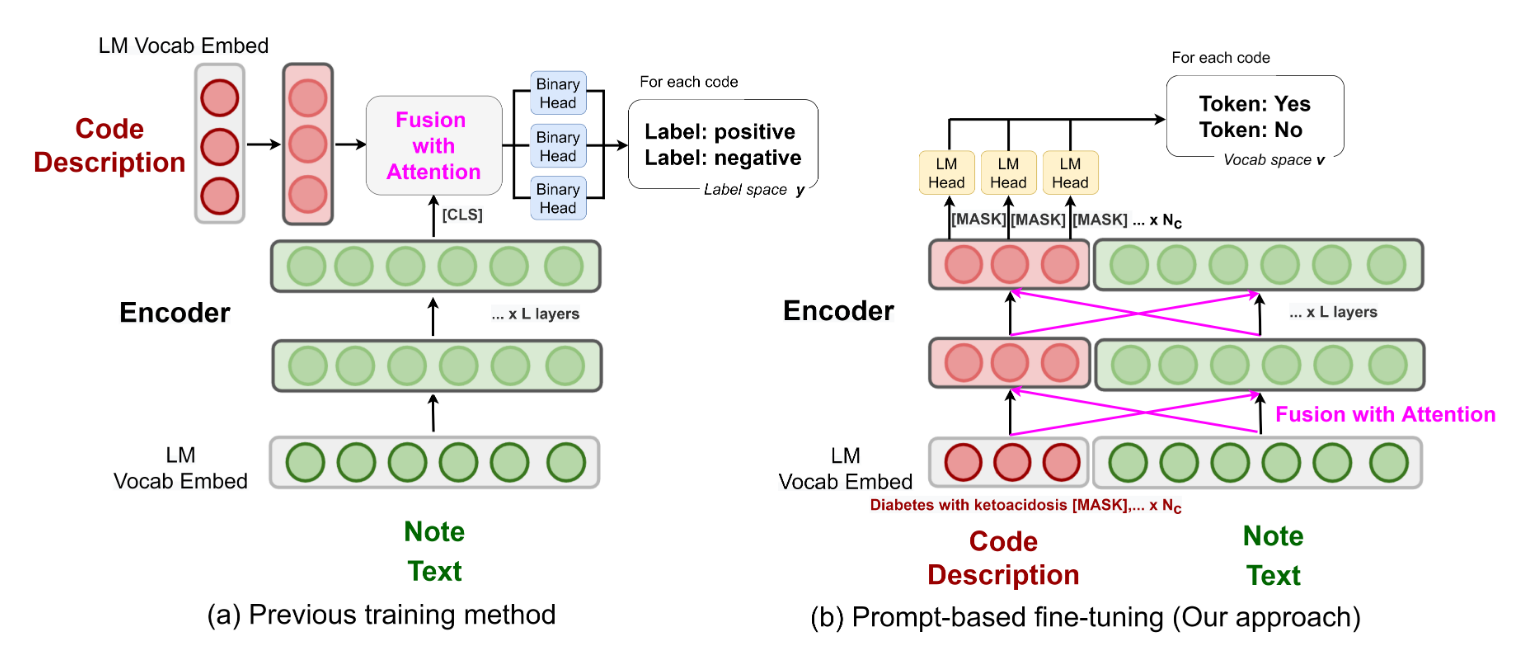

输入格式:疾病a描述+[MASK]+疾病b描述+[MASK]+…+病历文本,通过MLM来预测疾病的有无

使用超长文本专用的LongFormer(8192个token,全局注意力)来处理,使用注意力机制来捕获每一种疾病的相关信息,从而根据不同位置编码的MASK来预测不同疾病的有无

- 计算量随类别数增加(N^2),因此无法处理超大类别

Details #

Pretrain,1张V100,48小时

Finetune, 2张A100,10+0.5小时(MIMIC-III-50 & MIMIC-III-rare50)

计算量随类别数增加(N^2),因此无法处理超大类别 因此,它在MIMIC III上的SOTA是通过2-stage取得的,先使用之前的sota模型选出300个candidate,再进一步计算